Server-Virtualisierung

Server sind Maschinen die gemeinsam ein Computernetzwerk bilden und Dateien, sowie Applikationen zur Verfügung stellen, welche wiederum verschiedene Services bereitstellen. Es liegt in der Hand der Server-Administratoren den Servern bestimmte Aufgaben bzw. Applikationen zu zu weisen. Oft ist es nun so das diese Applikationen eigenständige Server benötigen, da diese nicht mit anderen Applikationen zusammen oder auf dem gleichen Betriebssystem bzw. der gleichen Hardware installiert werden können. Außerdem lässt sich ein Problem schneller lokalisieren, wenn eine Applikation nur auf einem Server beheimatet ist.

Allerdings hat diese Konstellation der Serverstruktur das Problem, das die heute zur Verfügung gestellten Serverkapazitäten nicht vollends ausgenutzt werden, da große Teile der Rechenleistungen in diesen Servern ungenutzt bleiben.

Zudem werden durch diese Architektur die IT-Netzwerke immer größer und komplexer, wobei sie dadurch auch immer mehr physikalischen Platz benötigen. Diese Unmenge an Serverracks in den großen Datacentern fressen eine riesige Menge an Energie und erzeugen eine enorme Hitze.

Um diesen Problemen entgegenzutreten gibt es schon seit über 12 Jahren die Servervirtualisierung, wobei immer noch viele Unternehmen diese Technologie scheuen.

Was ist denn nun eigentlich Servervirtualisierung?

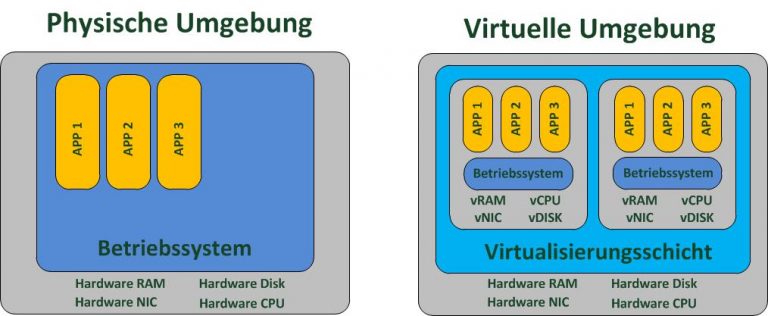

Eine Servervirtualisierung bedeutet die Unterteilung eines physikalischen Servers in mehrere einzelne virtuelle Maschinen (Server). Wobei diese voneinander vollkommen isoliert sind, aber die gleiche physikalische Hardware nutzen. Hierbei wir eine Abstraktionsebene (der sogenannte Hypervisor) zwischen die Hardware und das Betriebssystem geschoben. Diese Abstraktionsebene ermöglicht das erstellen virtueller Maschinen, die einen physikalischen Server inkl. des RAM, CPU, Disks und allen Schnittstellen emuliert. Doch arbeiten diese Virtualisierungssysteme nicht wie die klassischen Emulatoren, da sie direkt mit der physikalischen Host-Hardware zusammen arbeiten. Es werden nur Peripherie und diverse Einsteckkarten wie Grafikkarte oder Festplattencontroller emuliert. Ziel einer solchen Virtualisierung ist die Konsolidierung von vielen wenig ausgelasteten Servern auf wenig gut ausgelastete Server!

Welche Arten der Virtualisierung gibt es denn nun?

Man unterscheidet bei der Virtualisierung zwischen 3 Arten:

1. Virtuelle Maschinen

Die Variante der virtuellen Maschinen funktioniert nach dem Host-Gast Prinzip. Wobei hier der physische Server (Hardware) als Host Maschine dient und die virtuellen Maschinen (die VM’s) als Gäste fungieren. Für jede Gastmaschine wir die Hardwareebene separat emuliert, hierdurch ist es möglich mehrere Gäste auf dem Host parallel laufen zu lassen. Diese laufen komplett isoliert und unabhängig voneinander. Somit ist es auch möglich verschiedene Betriebssysteme parallel laufen zu lassen. Die VM’s können auch komplett unabhängig voneinander rebootet werden. Die VM’s haben auch keine Berührungspunkte untereinander oder zur Host Hard- oder Software. Sie arbeiten wie mit realen physischen Komponenten.

Der Hypervisor (Virtual Machine Monitor – VMM) koordiniert alle Kommandos zur CPU. Er ist für die Überwachung aller Ressourcen zuständig und verwaltet und bestätigt jedweden ausgeführten Code. Dieses Emulieren kostet das Gesamtsystem auch etwas an Systemleistung, man spricht hierbei von „Virtualisierungsschwund“. Je nach Virtualisierungslösung kann dieser bei 5 – 25% liegen. Neuere Lösungen versuchen diesen Schwund mittels einer effizienteren Kontrolle so niedrig wie möglich zu halten.

2. Paravirtuelle Maschinen

Auch diese Variante stützt sich auf das Host-Gast Prinzip und bringt ebenso einen Hypervisor bzw. VMM zum Einsatz. Anders als bei den virtuellen Maschinen kommunizieren die einzelnen Gäste dieser Variante direkt mit dem Hypervisor bzw. VMM und nicht direkt mit der physikalischen Hardware. Hierbei weiß das Gastsystem von der virtuellen Hardware und nutzt daher eine angepasste Version. Ebenso wissen alle VM’s voneinander und kennen ihre jeweiligen Anforderungen an die Rechenleistungen. Alle Gäste-VM’s bilden so eine Einheit, wodurch die physikalische Hardware dynamisch an die jeweiligen Anforderungen der einzelnen Gäste angepasst werden kann. Durch dieses Prinzip wird der Hypervisor sehr stark entlastet, da nur noch eine virtuelle Hardware abgebildet werden muss. Dadurch ist auch der Gast-Zugriff auf die physikalische Hardware enorm verbessert.

3. Virtualisierung auf Betriebssystem-Ebene

Zum Vergleich zu den beiden vorherigen varianten gibt es hier nur ein Betriebssystem – und zwar das des physikalischen Servers. Dieses Betriebssystem übernimmt alle Funktionen des Hypervisors. Jede VM arbeitet unabhängig, wobei einzelne Fehler die anderen VM’s nicht beeinträchtigen. Jedoch läuft alles auf dem gleichen Betriebssystem, wobei dessen Bibliotheken und Programme auch gemeinsam genutzt werden, dies betrifft auch die laufenden Prozesse. Alle Systemaufrufe zwischen den Schichten sind beseitigt um die CPU-Auslastung zu reduzieren und somit die Arbeitsgeschwindigkeit zu erhöhen. Ein solcher virtueller Server hat auch einen sehr geringen Bedarf an Arbeitsspeicher.

Wann ist eine Servervirtualisierung eigentlich sinnvoll?

Generell ist hier anzumerken: Immer wenn es ungenutzte Ressourcen auf Servern gibt. Technisch macht eine Virtualisierung aber erst ab ca. 5 Servern Sinn, da bei weniger Servern das Ausfallrisiko durch die Konsolidierung zu hoch wäre.

Natürlich sollte vorab auch eine Bedarfsanalyse durchgeführt werden. Da Virtualisierungsprojekte sehr komplex werden können, kann es schnell ohne Bedarfsanalyse bei kleinen oder mittelständigen Betrieben zu einer Über- oder Unterdimensionierung bei den Investitionen kommen. Im besten Fall ist dies dann nur teuer, aber im schlimmsten Fall kann es zu einer Nichtfunktion des Gesamtsystems führen. Allerdings sollte man bei Ressourcen intensiven Anwendungen, welche viel CPU, RAM oder Speicher benötigen eine Virtualisierung genausten überlegen.

Welche Vorteile haben eigentlich Servervirtualisierungen?

Wird eine Servervirtualisierung richtig umgesetzt, profitiert der Anwender von einer ganzen Reihe an Vorteilen die den Arbeitsprozess und die Hardware-Funktionalität optimieren:

1. Optimale Auslastung der Hardware

Die diversen Tools und Applikationen müssen nicht mehr auf eigenen Servern isoliert werden. Bei den virtuellen Servern können Anwendungen und Server sauber von einander isoliert werden. Dies spart nicht nur an Hardware, sondern sorgt auch für eine optimale Auslastung der CPU, RAM und Speicher.

2. Einsparung an Platz- und Energie

Da durch die Virtualisierung immer weniger physikalische Server etc. benötigt werden kommt es zwangsläufig zu immer kleiner werdenden Rechenzentren und eine enorme Einsparung an Energiekosten.

3. Es können alte Anwendungen auf modernster Hardware betrieben werden

Durch die Virtualisierung können alte Anwendungen, die auf neuer Hardware nicht mehr laufen würden, auf virtuellen Maschinen weiter betrieben werden. Hierzu wird einfach die alte Hardware und das alte Betriebssystem emuliert.

4. Anpassungen sind problemlos möglich

Durch die Unabhängigkeit zur Hardware können virtuelle Maschinen sehr einfach migriert und verschoben werden. Somit können Wartungszeiten optimal geplant werden und Systeme im laufenden Betrieb von einem zum anderen Server migriert werden.

5. Kosteneinsparungen

Kleinere Rechenzentren bedeuten weniger Energie- und Hardwarekosten. Zudem fallen weniger Wartungskosten an.

6. IT-Management wird flexibler

Durch die Virtualisierung ist es möglich das der IT-Administrator auch aus dem Home-Office die Server administriert.

7. Aufbau eigener Testcenter

Bei frei werdenden virtuellen wie auch physikalischen Servern, können diese sehr gut auch für ein eigenes Testcenter für eigene Applikationen zum testen genutzt werden.

8. Kein Lock-In des Anwenders

Es kann neue Hardware sehr schnell virtualisiert bereitgestellt werden kann, da der virtuelle Server unabhängig von der zugrunde liegenden Hardware läuft.

9. Cloud-Computing möglich

Hat ein Unternehmen einmal die Richtung zu den virtuellen Servern eingeschlagen, ist die Cloud auch nicht mehr weit entfernt. Da das Unternehmen nun mit den von der Hardware-Schicht abgekoppelten Servern im firmeninternen Rechenzentrum auch für seine Mitarbeiter oder Kunden sogenannte private Clouds anbieten kann.

10. Einfaches Virtuelles Disaster Recovery

Da die VM’s eine gewisse Unabhängigkeit zur Host-Hardware haben, können Tools und Applikationen relativ einfach gespiegelt werden. Zudem fällt die Hardware-Dimensionierung viel kleiner aus. Ebenso sind meistens diverse Softwaretools für einen automatisierten Failover-Prozess bei den gängigen Virtualisierungslösungen mit dabei.

Ihre Anforderungen, unser KnowHow

Die SYSM ist Ihr kompetenter Ansprechpartner wenn es um Server-Virtualisierung Lösungen geht. Wir bieten Ihnen umfassende Dienstleistungen und Produkte für die Planung, Umsetzung und Betreuung rund um die Themen einer kompletten Server-Virtualisierung Lösung an. Unser höchstes Ziel ist es den maximalen Mehrwert für Sie zu erzielen und somit gemeinsam Ihre Projekte zum Erfolg zu führen. Dafür stehen wir Ihnen mit unseren Server-Virtualisierung Experten zur Verfügung.

Testen Sie unser KnowHow im Bereich Server-Virtualisierung. Wir stellen Ihnen unsere Server-Virtualisierung Experten gerne zur Verfügung.

Michael Schwab Geschäftsführer